Noticias Destacadas

Modificación sustancial del Plan de Estudios del Grado en Matemáticas (acuerdo del Consejo de Gobierno de la UAM de 08/11/2023). Pendiente de aprobación por la Fundación Madri+d. Está previsto que la modificación se aplique, para todos los cursos del grado, en el año académico 2025-2026.

- Información (provisional) sobre grupos y horarios de las asignaturas impartidas por el Departamento de Matemáticas, para el curso 2024-2025.

- Propuestas de Trabajos de Fin de Grado para el curso 2024-2025.

|

Premios a Favor de Jóvenes InvestigadoresNuestro compañero José Manuel Conde Alonso ha sido galardonado en la modalidad de “Ciencias Matemáticas y Física Teórica” en los Premios a Favor de Jóvenes Investigadores de la UAM. El objetivo principal de estos premios es el de reconocer y visibilizar el trabajo de los investigadores jóvenes de la UAM por su contribución al desarrollo científico, así como a su visualización nacional e internacional como centro investigador de referencia. |

|

Premio SeMA al mejor artículo del SeMA Journal de 2023En esta edición el artículo galardonado ha sido "Finite difference schemes for the parabolic p-Laplace equation", SeMA Journal volume 80, pages 527-547 (2023) elaborado por los profesores Félix del Teso de la Universidad Autónoma de Madrid y Erik Lindgren del KTH-Royal Institute of Technology de Estocolmo. |

|

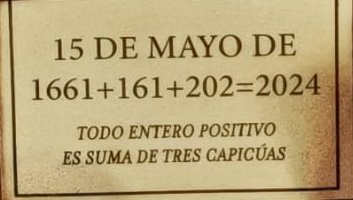

Plaza Jardín matemático Javier CillerueloEl pasado 15 de mayo tuvo lugar en su ciudad natal, Aranda de Duero, un homenaje a nuestro compañero Francisco Javier Cilleruelo Mateo, fallecido en la misma fecha de hace ocho años. En el acto se inauguró la plaza-jardín que llevará su nombre, entre dos centros educativos que disfrutó en su niñez. |

|

Premio Ferran Sunyer i Balaguer 2024Antonio Córdoba, catedrático emérito de nuestro departamento y miembro del ICMAT, ha sido el ganador del Premio Internacional de Investigación Matemática Ferran Sunyer i Balaguer 2024 por su monografía Suprematism in Harmonic Analysis. La monografía será publicada en la serie ‘Progress in Mathematics’ de la editorial Birkhäuser. |

|

Quinta edición del Campamento de verano UAMMATDel 27 de junio al 5 de julio de 2024 tendrá lugar la quinta edición del Campamento de verano UAMMAT, organizado por el Departamento y destinado a alumnos de 1º de Bachillerato. El plazo de inscripción está abierto hasta el 12 de abril de 2024. |

|

Canal @matematicasuamEnlace al canal del Departamento en youtube. |

PIM (Pequeño Instituto de Matemáticas)Con el objetivo de fomentar el interés por las matemáticas y dirigido a jóvenes entre 12 y 18 años, nació este proyecto de Instituto de Ciencias Matemáticas (ICMAT) en colaboración con nuestro Departamento, la Universidad Autónoma de Madrid y la Real Sociedad Matemática Española. El proyecto arrancó en el curso académico 2022-2023, y el registro al mismo está abierto todo el año. Ampliar información en su página web. |

Noticias Anteriores

Noticias Anteriores